El aprendizaje profundo (o deep learning) es una subdisciplina del aprendizaje automático que está revolucionando áreas como el reconocimiento de imágenes, la traducción automática y el procesamiento del lenguaje natural. Python es uno de los lenguajes más populares para trabajar en este campo debido a su simplicidad y a la cantidad de bibliotecas especializadas que facilitan el desarrollo de modelos. Si te interesa aprender cómo empezar en el aprendizaje profundo usando Python, este artículo te guiará paso a paso en lo básico para que puedas dar tus primeros pasos.

¿Qué es el aprendizaje profundo?

El aprendizaje profundo se basa en redes neuronales artificiales que imitan la forma en que funciona el cerebro humano. Estas redes están compuestas por capas de nodos (o «neuronas») que procesan datos y ajustan sus pesos en función del error que cometen. La característica clave de estas redes es la capacidad de tener múltiples capas ocultas, lo que permite que la red detecte patrones complejos y relaciones en los datos.

Por qué usar Python para el aprendizaje profundo

Python es la opción preferida para desarrollar modelos de aprendizaje profundo debido a varios factores:

- Sintaxis simple: Python tiene una sintaxis sencilla, lo que facilita el desarrollo de modelos complejos sin distraerse con la sintaxis del código.

- Bibliotecas especializadas: Hay muchas bibliotecas potentes, como TensorFlow, Keras y PyTorch, que simplifican la implementación de redes neuronales.

- Gran comunidad de usuarios: Python cuenta con una comunidad activa que contribuye a la creación de tutoriales, recursos y soluciones a problemas comunes.

Paso 1: Instala las bibliotecas necesarias

Para comenzar con el aprendizaje profundo en Python, necesitas instalar algunas bibliotecas. Las más comunes son TensorFlow y Keras, ya que ofrecen una forma sencilla de definir y entrenar redes neuronales.

Puedes instalarlas usando pip:

pip install tensorflow keras

Además de TensorFlow y Keras, es recomendable instalar bibliotecas para manipular datos, como NumPy y pandas:

pip install numpy pandas

Paso 2: Comprender el flujo de trabajo de un modelo de aprendizaje profundo

El flujo de trabajo básico para crear un modelo de aprendizaje profundo en Python sigue estos pasos:

- Preparar los datos: Recopila y preprocesa los datos que vas a utilizar para entrenar tu modelo.

- Definir la arquitectura del modelo: Diseña la estructura de la red neuronal, es decir, el número de capas y neuronas por capa.

- Compilar el modelo: Configura el modelo con un optimizador, una función de pérdida y métricas de evaluación.

- Entrenar el modelo: Alimenta los datos al modelo y ajusta sus pesos mediante un proceso llamado entrenamiento.

- Evaluar el modelo: Una vez entrenado, evalúa el rendimiento del modelo en un conjunto de datos que no ha visto antes.

- Hacer predicciones: Finalmente, usa el modelo entrenado para hacer predicciones sobre nuevos datos.

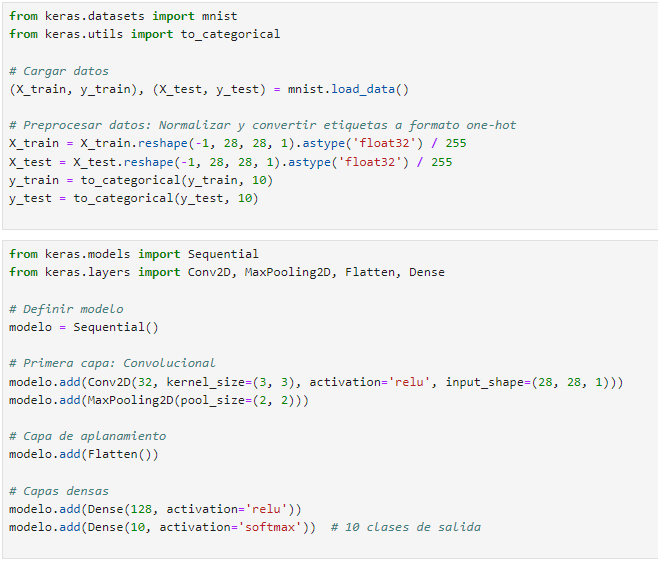

Paso 3: Prepara los datos

Para entrenar una red neuronal, necesitarás un conjunto de datos. Un conjunto de datos comúnmente usado para comenzar es el MNIST, que contiene imágenes de dígitos escritos a mano. Puedes cargar este conjunto de datos directamente desde Keras:

from keras.datasets import mnist

from keras.utils import to_categorical

# Cargar datos

(X_train, y_train), (X_test, y_test) = mnist.load_data()

# Preprocesar datos: Normalizar y convertir etiquetas a formato one-hot

X_train = X_train.reshape(-1, 28, 28, 1).astype('float32') / 255

X_test = X_test.reshape(-1, 28, 28, 1).astype('float32') / 255

y_train = to_categorical(y_train, 10)

y_test = to_categorical(y_test, 10)

Paso 4: Definir la arquitectura del modelo

Para definir el modelo de red neuronal, usaremos Keras. Un ejemplo básico de una red neuronal para clasificación de imágenes podría ser:

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

# Definir modelo

modelo = Sequential()

# Primera capa: Convolucional

modelo.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(28, 28, 1)))

modelo.add(MaxPooling2D(pool_size=(2, 2)))

# Capa de aplanamiento

modelo.add(Flatten())

# Capas densas

modelo.add(Dense(128, activation='relu'))

modelo.add(Dense(10, activation='softmax')) # 10 clases de salida

Este es un ejemplo básico de una red convolucional que es eficaz para tareas de reconocimiento de imágenes. Puedes experimentar con diferentes capas y configuraciones para mejorar el rendimiento del modelo.

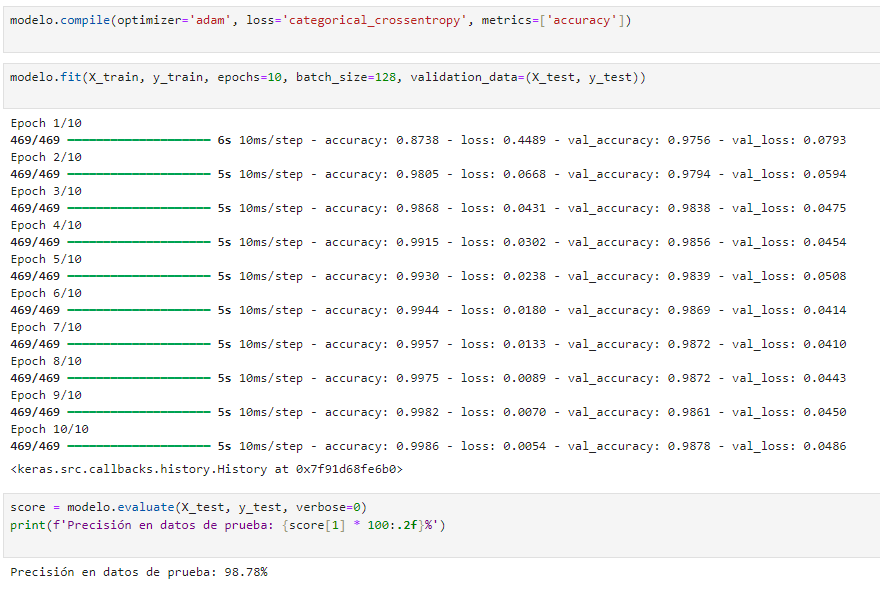

Paso 5: Compilar el modelo

El siguiente paso es compilar el modelo, es decir, configurarlo para el entrenamiento. Necesitas especificar una función de pérdida, un optimizador y las métricas que se utilizarán para evaluar el rendimiento del modelo.

modelo.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

En este ejemplo, usamos el optimizador Adam y la función de pérdida categorical_crossentropy, que es adecuada para la clasificación multiclase.

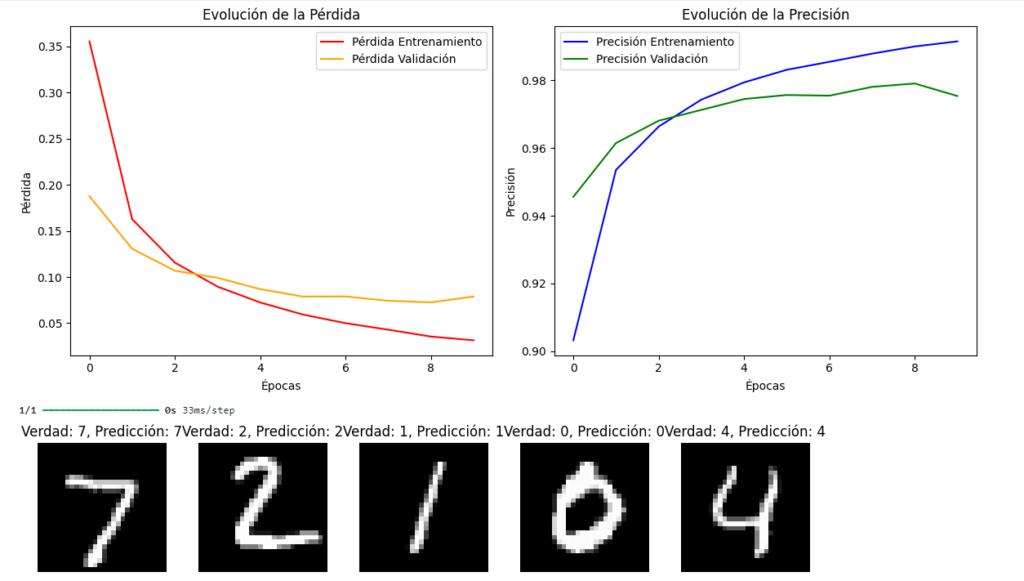

Paso 6: Entrenar el modelo

Con el modelo definido y compilado, ahora puedes entrenarlo con los datos de entrenamiento:

modelo.fit(X_train, y_train, epochs=10, batch_size=128, validation_data=(X_test, y_test))

El modelo se entrenará durante 10 épocas (ciclos completos a través del conjunto de datos), y al final de cada época, se evaluará en los datos de prueba.

Paso 7: Evaluar el rendimiento

Una vez que el modelo está entrenado, puedes evaluar su rendimiento en los datos de prueba:

score = modelo.evaluate(X_test, y_test, verbose=0)

print(f'Precisión en datos de prueba: {score[1] * 100:.2f}%')

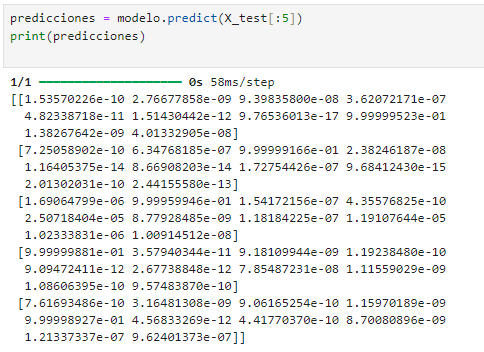

Paso 8: Hacer predicciones

Finalmente, puedes usar el modelo para hacer predicciones sobre nuevas muestras de datos:

predicciones = modelo.predict(X_test[:5])

print(predicciones)

Esto generará las predicciones del modelo sobre los primeros cinco ejemplos de los datos de prueba.

Conclusión

El aprendizaje profundo en Python es accesible gracias a bibliotecas como Keras y TensorFlow, que facilitan la implementación de redes neuronales complejas. Este artículo ha cubierto los primeros pasos para empezar en este campo, desde la instalación de las herramientas hasta el entrenamiento de tu primer modelo. Con la práctica y la experimentación, podrás adentrarte en técnicas más avanzadas y resolver problemas complejos en áreas como visión artificial y procesamiento del lenguaje natural.