Introducción al Web Scraping

El web scraping es una técnica ampliamente utilizada para extraer datos de sitios web, y aunque puede ser beneficiosa, también plantea riesgos significativos para la seguridad y la integridad de la información. Si bien no todo el scraping es malintencionado, muchas veces se utiliza para recopilar datos de manera ilegal o sin consentimiento, lo que puede afectar a la reputación y al rendimiento de tu sitio.

Este artículo aborda las principales estrategias de protección contra scraping, así como las mejores prácticas para salvaguardar tus datos y mantener la integridad de tu sitio web.

¿Por Qué Proteger Tu Sitio Contra Scraping?

- Robo de contenido: Los scrapers pueden robar tu contenido original, afectando tu autoridad SEO y haciendo que tu sitio pierda tráfico debido a contenido duplicado.

- Competencia desleal: Algunos competidores pueden utilizar scraping para recopilar datos sobre tus precios, productos o estrategias de marketing, lo que les permite tener una ventaja competitiva.

- Uso indebido de datos: El scraping malicioso puede llevar al uso indebido de información sensible, lo que puede resultar en sanciones legales y dañar tu reputación.

- Impacto en el rendimiento: El scraping excesivo puede generar cargas en tu servidor, afectando la velocidad de carga y la experiencia del usuario, lo que a su vez puede influir en tu posicionamiento SEO.

Estrategias de Protección Contra Scraping

1. Implementar Captchas

Los captchas son una de las herramientas más efectivas para prevenir el scraping automatizado. Obligan a los usuarios a demostrar que son humanos antes de acceder a ciertas partes de tu sitio.

- Impacto SEO: Aunque pueden afectar la experiencia del usuario, su correcta implementación puede prevenir el scraping y asegurar que el tráfico que recibes sea legítimo.

2. Utilizar la Autenticación de Usuarios

Requerir que los usuarios se registren o inicien sesión para acceder a contenido específico es una estrategia efectiva para proteger datos sensibles. Esto crea una barrera para los scrapers que no pueden completar el proceso de autenticación.

- Beneficio SEO: Si el contenido es exclusivo y valioso, fomentará el registro de usuarios, lo que puede resultar en una comunidad más comprometida y tráfico recurrente.

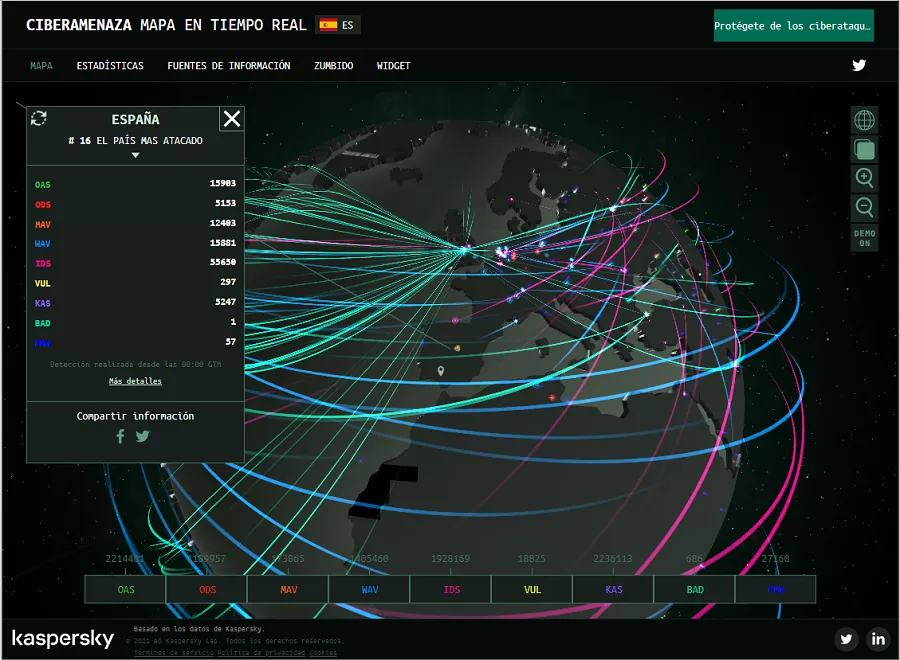

3. Monitoreo de Tráfico Anómalo

Implementar herramientas de análisis de tráfico que detecten patrones inusuales, como un número elevado de solicitudes desde una misma dirección IP en un corto periodo, puede ayudarte a identificar intentos de scraping.

- Impacto SEO: Al detectar y bloquear el tráfico no deseado, puedes mejorar la velocidad de carga de tu sitio y mantener una buena experiencia de usuario, lo que es fundamental para el SEO.

4. Uso de IPs Dinámicas y Proxies

El uso de IPs dinámicas o proxies puede ayudar a distribuir el tráfico y dificultar que los scrapers accedan a tu sitio web. Esto puede ser especialmente útil para sitios que experimentan un alto volumen de scraping.

- Efecto SEO: Al mantener un acceso seguro y controlado a tu sitio, puedes evitar la penalización de motores de búsqueda por prácticas de scraping desleal.

5. Configurar el Archivo Robots.txt

El archivo robots.txt permite a los propietarios de sitios web especificar qué partes de su sitio pueden ser accedidas por bots y scrapers. Asegúrate de configurarlo correctamente para proteger las secciones más sensibles de tu sitio.

- Beneficio SEO: Al guiar a los motores de búsqueda sobre cómo indexar tu contenido, puedes optimizar el rendimiento SEO y proteger áreas que no deseas que sean scrapeadas.

Herramientas para Proteger Tu Sitio Contra Scraping

- Cloudflare: Esta herramienta ofrece una variedad de medidas de seguridad, incluidos firewalls y protecciones DDoS, que pueden ayudar a prevenir el scraping.

- DataDome: DataDome es una solución de ciberseguridad que utiliza inteligencia artificial para identificar y bloquear bots maliciosos en tiempo real.

- Distil Networks: Esta plataforma ayuda a proteger tu sitio de bots de scraping y automatiza la detección y bloqueo de tráfico sospechoso.

- Sucuri: Sucuri proporciona un firewall y un sistema de monitoreo que te ayuda a proteger tu sitio de ataques, incluido el scraping.

Mejores Prácticas para la Protección Contra Scraping

- Mantén tu software actualizado: Asegúrate de que tu CMS, plugins y otros software estén siempre actualizados para prevenir vulnerabilidades que puedan ser explotadas por scrapers.

- Realiza auditorías de seguridad periódicas: Evaluar la seguridad de tu sitio regularmente puede ayudarte a identificar y solucionar puntos débiles.

- Educa a tu equipo: Asegúrate de que todos los miembros de tu equipo comprendan la importancia de la seguridad y cómo proteger el contenido y los datos de la empresa.

- Considera soluciones de monitoreo de contenido: Utiliza herramientas que te permitan rastrear si tu contenido ha sido copiado en otros sitios web, para tomar medidas en caso de que se produzca un robo.

Conclusión

La protección contra scraping es esencial para salvaguardar tu contenido, datos y la integridad de tu sitio web. Implementando técnicas y herramientas adecuadas, puedes prevenir el scraping malicioso y proteger tu negocio de las repercusiones negativas. Además, al mantener la seguridad y el rendimiento de tu sitio, estarás mejor posicionado para lograr un SEO efectivo y atraer tráfico legítimo y valioso.