A continuación, te explico la Instalación de Stable Video Diffusion (SVD) en tu servidor con Ubuntu 24.04, asegurándote de que aproveche tu GPU NVIDIA. Este proceso asume que tienes una GPU compatible con CUDA (como una NVIDIA GTX/RTX) y al menos 4 GB de VRAM (8 GB o más es ideal) en mi caso una 4046 Ti con 16 GB de VRAM.

Instalación de Stable Video Diffusion (SVD) en Ubuntu 24.04 Paso a Paso

Requisitos previos

- Ubuntu 24.04 instalado.

- GPU NVIDIA con drivers y CUDA instalados.

- Python 3.10 o 3.12 (Ubuntu 24.04 suele venir con Python 3.12 por defecto).

- Al menos 10 GB de espacio libre en disco para el modelo y dependencias.

- Acceso a internet para descargar el repositorio y modelos.

- Opcional: Cuenta en Hugging Face para descargar modelos preentrenados.

Opciones para generar videos con alta calidad

Aquí están las principales herramientas de código abierto para generar videos, ordenadas por calidad percibida (basada en resultados visuales, resolución, coherencia y soporte de la comunidad).

1. Stable Video Diffusion (SVD)

- Descripción: Desarrollado por Stability AI, Stable Video Diffusion es una extensión del modelo Stable Diffusion optimizada para generar videos cortos (generalmente de 2 a 30 segundos) a partir de texto o imágenes iniciales. Ofrece dos modelos principales: SVD (para generación desde texto o imagen) y SVD-XT (mejorado para mayor coherencia y calidad).

- Calidad: Alta. Genera videos con buena coherencia temporal, detalles nítidos y resoluciones de hasta 576×1024 (o más con ajustes). Los resultados son competitivos con herramientas comerciales, especialmente en animaciones estilizadas o realistas cortas. La calidad mejora con modelos fine-tuned disponibles en la comunidad (por ejemplo, en Hugging Face).

- Ventajas:

- Resultados de alta calidad con prompts bien definidos.

- Compatible con flujos de trabajo personalizados (por ejemplo, ComfyUI).

- Comunidad activa con modelos preentrenados y soporte.

- Limitaciones:

- Requiere configuración adicional para obtener los mejores resultados.

- Los videos son cortos (hasta 25 fotogramas por defecto, aunque se puede extender).

- Necesita prompts precisos para evitar artefactos.

2. VideoCrafter

- Descripción: VideoCrafter es un modelo de código abierto desarrollado por AILab-CVC, diseñado para generar videos a partir de texto o imágenes. Soporta resoluciones de hasta 720×1280 y es conocido por su flexibilidad en estilos (realistas, animados, etc.).

- Calidad: Muy buena. Los videos tienen buena coherencia temporal y detalles visuales, aunque puede ser ligeramente inferior a SVD-XT en escenarios realistas. Es ideal para animaciones estilizadas o videos artísticos.

- Ventajas:

- Fácil de instalar y configurar.

- Soporta múltiples estilos y personalización.

- Buena documentación y comunidad.

- Limitaciones:

- Menos coherencia en videos largos comparado con SVD.

- Requiere ajuste de hiperparámetros para obtener resultados óptimos.

3. CogVideo

- Descripción: CogVideo, desarrollado por THUDM, es otro modelo de código abierto para generar videos a partir de texto. Está optimizado para prompts detallados y puede generar videos de hasta 480×480 (o más con upscaling).

- Calidad: Buena, pero inferior a SVD y VideoCrafter. Los videos tienen coherencia aceptable, pero los detalles y la resolución son menos impresionantes. Es mejor para experimentos rápidos o videos estilizados.

- Ventajas:

- Ligero en recursos (funciona bien con 16 GB de VRAM).

- Fácil de integrar con otros flujos de trabajo.

- Limitaciones:

- Resoluciones más bajas por defecto.

- Menos soporte comunitario comparado con SVD o VideoCrafter.

4. Deforum (Extensión para Stable Diffusion WebUI)

- Descripción: Deforum es una extensión para la Stable Diffusion WebUI de AUTOMATIC1111 que genera animaciones o videos interpolando imágenes. No es un modelo de video dedicado, sino un flujo de trabajo que crea secuencias de imágenes animadas.

- Calidad: Buena para animaciones estilizadas, pero limitada para videos realistas. Los resultados dependen de la calidad del modelo de Stable Diffusion subyacente (por ejemplo, SDXL). Puede generar videos en resoluciones altas (hasta 1080p), pero la coherencia temporal no es tan buena como SVD o VideoCrafter.

- Ventajas:

- Fácil de integrar si ya usas Stable Diffusion WebUI.

- Altamente personalizable (movimientos de cámara, transiciones, etc.).

- Usa modelos de imágenes existentes, lo que reduce la necesidad de nuevos modelos.

- Limitaciones:

- No es un modelo de video nativo, por lo que la coherencia puede ser irregular.

- Requiere más configuración manual para resultados óptimos.

Comparación de calidad

| Herramienta | Calidad (1-5) | Resolución máxima | Coherencia temporal | Facilidad de uso | Recomendado para |

|---|---|---|---|---|---|

| Stable Video Diffusion (SVD-XT) | 5/5 | 576×1024 (o más con upscaling) | Excelente | Media | Videos realistas y estilizados |

| VideoCrafter | 4.5/5 | 720×1280 | Muy buena | Alta | Videos artísticos y estilizados |

| CogVideo | 3.5/5 | 480×480 (o más con upscaling) | Aceptable | Media | Experimentos rápidos |

| Deforum (WebUI) | 3.5/5 | 1080p (depende del modelo) | Regular | Media | Animaciones estilizadas |

Ganador en calidad: Stable Video Diffusion (SVD-XT). Es la opción que produce los videos de mayor calidad en términos de detalle, coherencia temporal y fidelidad visual, especialmente con mi GPU de 16 GB. Los resultados son comparables a herramientas comerciales en muchos casos, y la integración con ComfyUI facilita la personalización.

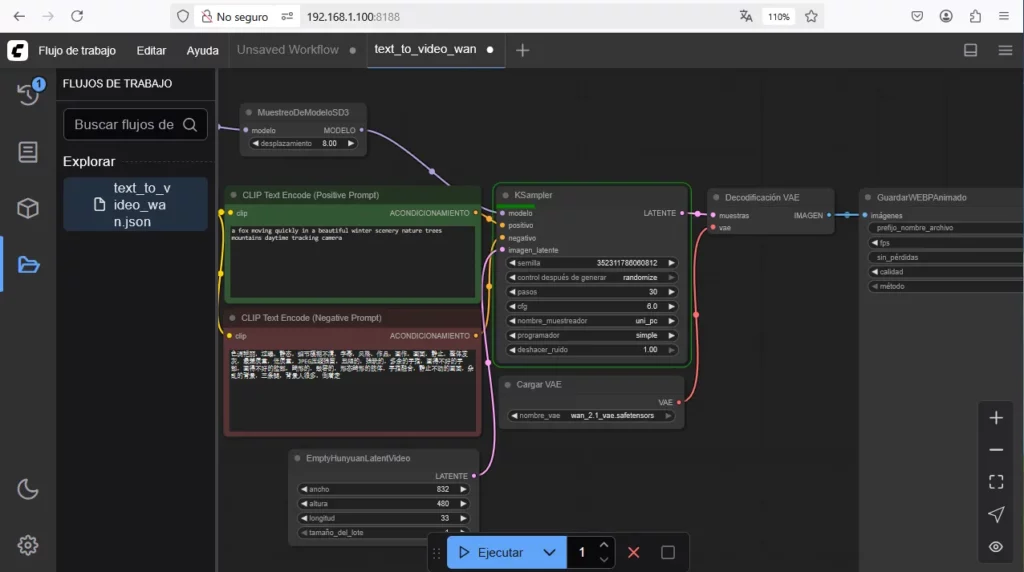

Pasos para Instalación de Stable Video Diffusion (SVD) con ComfyUI

Dado que SVD-XT es la mejor opción, aquí tienes un resumen de instalación optimizado:

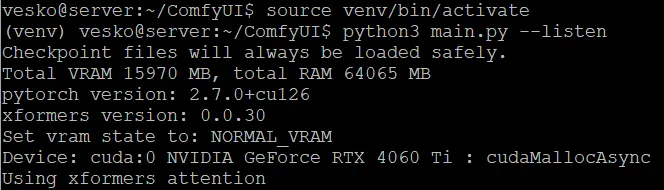

Instala ComfyUI:

git clone https://github.com/comfyanonymous/ComfyUI cd ComfyUI python3 -m venv venv source venv/bin/activate pip install -r requirements.txtAñade soporte para SVD:

Clona los nodos personalizados:

cd custom_nodes git clone https://github.com/kijai/ComfyUI-SVDInstala dependencias adicionales:

cd ComfyUI-SVD

pip install -r requirements.txtDescarga el modelo SVD-XT:

Ve a Hugging Face SVD-XT y descarga el archivo .safetensors.

Colócalo en ComfyUI/models/stable_video_diffusion/.

Ejecuta ComfyUI:

python main.py --listen

Configura el flujo de trabajo:

Accede a http://<tu-ip>:8188 en un navegador.

Carga un flujo de trabajo para SVD desde los ejemplos en el repositorio de comfyui-svd.

Ajusta los prompts y parámetros (por ejemplo, resolución, FPS).

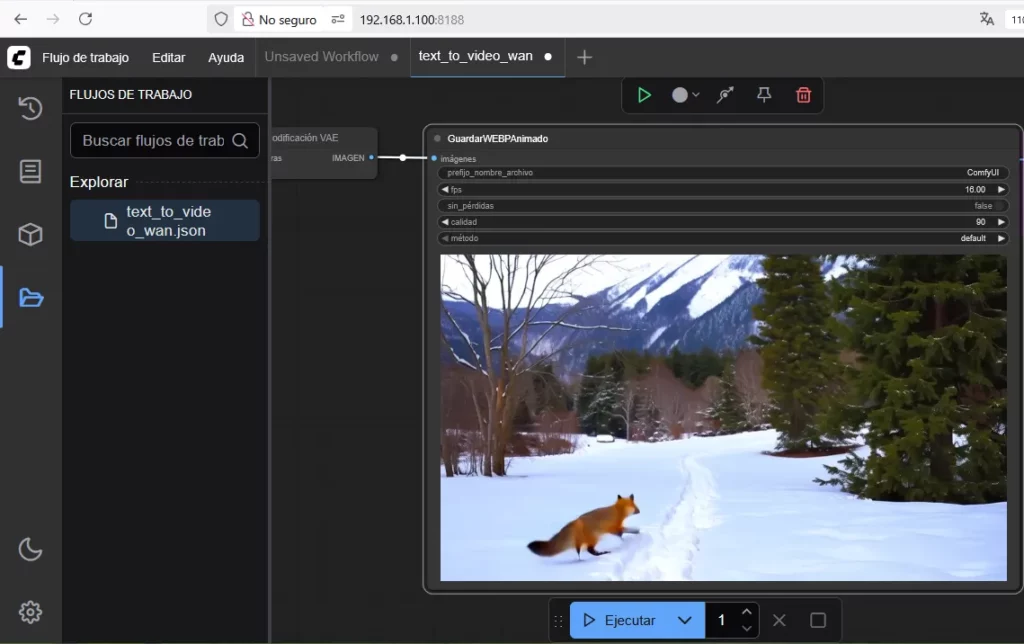

Genera videos:

Ejecuta el flujo y descarga el video generado (generalmente en formato MP4).

Notas adicionales Instalación de Stable Video Diffusion

- Optimización para 16 GB de VRAM: SVD-XT funciona bien con 16 GB, pero si encuentras problemas de memoria, reduce la resolución (por ejemplo, a 512×512) o ajusta el número de fotogramas (por ejemplo, 14 en lugar de 25).

- Upscaling: Para resoluciones más altas, usa herramientas como ESRGAN o Topaz Video AI (no libre) para mejorar los videos generados.

- Prompts efectivos: Usa prompts detallados y específicos (por ejemplo, «A futuristic city at sunset, cinematic lighting, highly detailed, 4k») para obtener mejores resultados.

- Comunidad: Busca flujos de trabajo preconfigurados para SVD en Civitai o en el Discord de Stability AI.

Si necesitas ayuda con la instalación, configuración de prompts o quieres explorar otra opción (como VideoCrafter), avísame y te guío paso a paso.