Introducción al Web Scraping: Herramientas de Web Scraping

El web scraping se ha convertido en una técnica vital para la obtención de datos en un mundo digital donde la información es abundante. Con las herramientas adecuadas, puedes extraer, organizar y analizar datos de forma rápida y eficiente, ayudando a las empresas y a los desarrolladores a tomar decisiones informadas. En este artículo, exploraremos las principales herramientas de web scraping, sus características y cómo elegir la adecuada para tus necesidades.

1. ¿Qué es una Herramienta de Web Scraping?

Las herramientas de web scraping son software diseñados para automatizar la extracción de datos de sitios web. Estas herramientas permiten a los usuarios recopilar información de múltiples fuentes de manera eficiente, sin la necesidad de hacerlo manualmente.

2. Beneficios de Utilizar Herramientas de Web Scraping

- Ahorro de tiempo: Automatizar la extracción de datos reduce significativamente el tiempo necesario para recopilar información.

- Precisión y Consistencia: Minimiza los errores humanos en la recopilación de datos, garantizando resultados más precisos.

- Acceso a Datos en Tiempo Real: Muchas herramientas permiten extraer datos en tiempo real, lo que es crucial para análisis de mercado y seguimiento de tendencias.

- Análisis Competitivo: Puedes obtener información sobre la competencia, como precios y productos, para ajustar tus estrategias de marketing.

3. Principales Herramientas de Web Scraping

A continuación, se presentan algunas de las herramientas de scraping más populares y sus características destacadas:

a) Scrapy

- Descripción: Scrapy es un framework de Python de código abierto, ideal para proyectos de scraping a gran escala.

- Características:

- Soporte para múltiples formatos de exportación (JSON, CSV, XML).

- Capacidad para manejar solicitudes concurrentes, aumentando la velocidad de scraping.

- Integración con otros módulos de Python para análisis de datos.

- Uso ideal: Proyectos complejos y aquellos que requieren un alto rendimiento.

b) BeautifulSoup

- Descripción: Una biblioteca de Python utilizada para parsear documentos HTML y XML.

- Características:

- Sencillez y facilidad de uso para principiantes.

- Permite navegar por la estructura del documento y extraer información fácilmente.

- Uso ideal: Proyectos pequeños y medianos, especialmente cuando se trabaja con HTML bien estructurado.

c) Selenium

- Descripción: Originalmente diseñada para pruebas automatizadas, Selenium también se utiliza para realizar scraping de sitios dinámicos que utilizan JavaScript.

- Características:

- Simulación de interacciones de usuarios reales en navegadores.

- Captura de contenido dinámico que no se carga inicialmente.

- Uso ideal: Extraer datos de aplicaciones web modernas y dinámicas.

d) Puppeteer

- Descripción: Una biblioteca de Node.js que proporciona una API de alto nivel para controlar Chrome o Chromium.

- Características:

- Soporte para scraping de contenido dinámico.

- Generación de capturas de pantalla y PDFs de páginas web.

- Uso ideal: Proyectos que requieren visualización de datos o extracción de contenido de aplicaciones web.

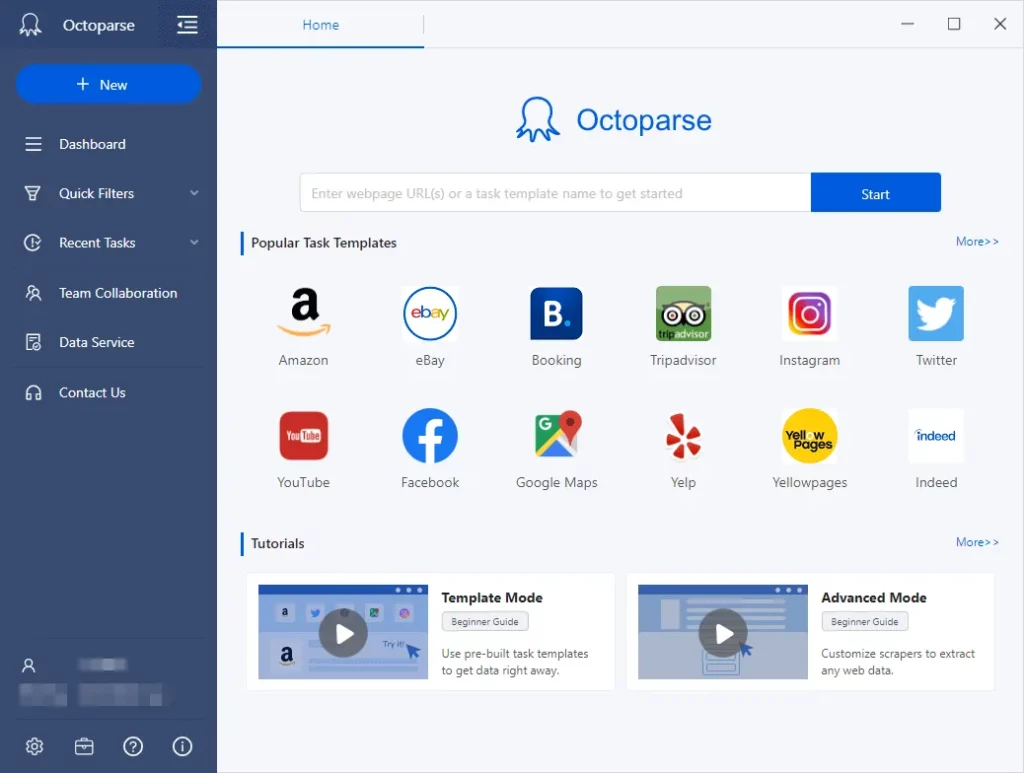

e) Octoparse

- Descripción: Una herramienta de scraping sin código que permite a los usuarios extraer datos sin necesidad de programar.

- Características:

- Interfaz visual intuitiva para seleccionar datos.

- Funciones avanzadas como programación de scraping y extracción en la nube.

- Uso ideal: Usuarios no técnicos que buscan una solución de scraping sencilla y efectiva.

4. Cómo Elegir la Herramienta de Web Scraping Adecuada

Al seleccionar una herramienta de web scraping, considera los siguientes factores:

- Nivel de experiencia: Si eres principiante, opta por herramientas con interfaces intuitivas, como Octoparse.

- Tipo de datos: Si necesitas extraer datos de sitios dinámicos, considera Selenium o Puppeteer.

- Escalabilidad: Para proyectos a gran escala, Scrapy es la mejor opción debido a su eficiencia y capacidad de manejo de grandes volúmenes de datos.

- Costo: Algunas herramientas son gratuitas (como Scrapy y BeautifulSoup), mientras que otras requieren suscripciones o licencias.

5. Buenas Prácticas al Usar Herramientas de Web Scraping

- Respetar las políticas de uso de los sitios web: Antes de hacer scraping, revisa los términos de servicio y las reglas de robots.txt.

- Evitar hacer scraping excesivo: Limita la cantidad de solicitudes para no sobrecargar el servidor y ser bloqueado.

- Almacenar datos de forma ética: Asegúrate de cumplir con las regulaciones de privacidad de datos, como el GDPR, al almacenar información personal.

Conclusión

Las herramientas de web scraping son esenciales para maximizar la eficiencia en la extracción de datos y ayudar a las empresas a mantenerse competitivas. Al elegir la herramienta adecuada y seguir buenas prácticas, puedes obtener información valiosa de manera legal y ética, mejorando así tus decisiones de negocio y estrategias de SEO.